Hintergrund

Apple iOS 14.5: Privatsphäre für das moderne Internet

von Dominik Bärlocher

Apple wird ein System ausrollen, das Kindesmissbrauch auf dem Smartphone aufspürt. Einer manuellen Überprüfung folgend sollen die Behörden verständigt werden. Das Feature klingt zwar gut, ist aber ein Alptraum für die Privatsphäre.

Apple will Massnahmen gegen Kinderpornografie und Kindesmissbrauch ergreifen und kündigt ein System an, das deine Bilder direkt auf dem Gerät analysiert und sie bei Verdacht von Menschen sichten lässt. Danach wird in den USA das National Center for Missing and Exploited Children (NCMEC) alarmiert. Apple hat dazu am Donnerstag ein White Paper veröffentlicht. Das System heisst NeuralHash und wird in kommenden Versionen von iOS 15 und iPadOS 15 ausgerollt.

Damit sticht Apple in ein Wespennest der Security: Sicherheit vs. Privatsphäre. Was ist wie schwer zu gewichten?

In dieser Geschichte gibt es wenige Fakten jenseits des White Papers, denn die Fragen, die NeuralHash aufwirft sind nicht auf eine Technologie und deren Implementation bezogen. Es geht um Menschenrechte. Daher ein Überblick, über all das, was du wissen musst, um den Rest des Artikels zu verstehen. Apropos: Im späteren Verlauf des Artikels verwende ich Apple stellvertretend für alle Technologiekonzerne, NeuralHash stellvertretend für alle Systeme, die nach ähnlichem Prinzip funktionieren.

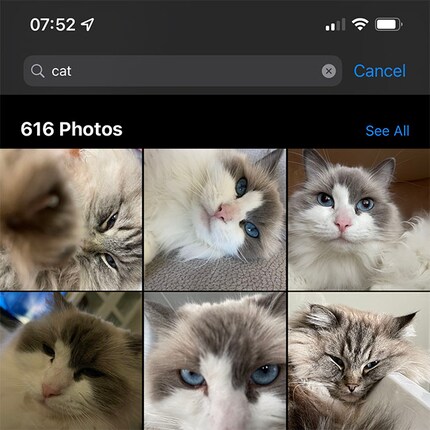

Dein Smartphone analysiert bereits Bilder nach ihrem Inhalt. Das kannst du einfach überprüfen. Mach deine Galerie-App auf, benutze die Suchfunktion. Wenn du nach «Katze» suchst, dann tauchen Bilder deiner Katze auf. Und die von anderen Katzen.

Das geschieht, indem die Galerie-App sogenannte Fingerprints auf dein Smartphone lädt. Also Parameter, die das Aussehen einer Katze definieren. Ein Teil dieser Parameter kannst du selbst definieren. Wenn ich ein Foto von Videoproduzentin Stephanie Tresch zur Hand nehme, dann kennt Apple Photos die Frau auf dem Bild nicht.

Ich kann ihr aber einen Namen zuweisen. Dann wird aus dem Datensatz «Frau» der Datensatz «Frau, Stephanie Tresch». Sobald Apple Photos weiss, dass die «Frau» auch «Stephanie Tresch» ist, dann wird ein Fingerprint für «Stephanie Tresch» erstellt. Augenfarbe, Wangenknochen, Lippen, Augenbrauen, Locations, Locations mit Objekten (zum Beispiel: «Zürich Hardbrücke» + «14 Uhr» + «blauer Mantel» + «Kamera» zeigt mir Bilder von Stephanie von hinten mit der Kamera im Anschlag), und so weiter.

Jede Bilddatei, genau wie jede andere Datei, hat eine eigene Nummer, die sich berechnen lässt. Ein sogenannter Hashwert. Dieser Hash ist kleiner als die Bilddatei, ist daher effizienter auf Datenbankebene.

Wenn du deiner besten Freundin ein Selfie schickst, dann bekommt dieses Bild einen Hashwert zugewiesen. Wenn sie es weiterschickt, dann hat das weitergeschickte Bild denselben Hash. Wenn das Bild aber verändert wird, von farbig zu schwarzweiss zum Beispiel, dann ändert sich auch der Hash.

So kann ein einzigartiges Bild verfolgt werden, wenn es von einer zentralen Instanz als «nicht gut» bezeichnet wird. Gerade bei unerlaubter Pornografie, wo Bilder die Runde machen, kann die Hash-Verfolgung zu schnellen Fahndungserfolgen führen. Wenn das Bild aber stets verändert wird, dann wird das mit dem Hash schwieriger.

Hashes können mit einfachen Mitteln manipuliert werden.

Das System NeuralHash ist bestätigt. Die Funktionsweise soll der Suchfunktion deiner Galerie-App gleichen. Das System indiziert automatisch Bilder nach gewissen Kriterien. Im Falle der aktuellen Story sind das Bilder von «Kindesmissbrauch». Wenn NeuralHash eine gewisse Anzahl von Bildern findet, die dem Fingerprint des «Kindesmissbrauch» entsprechen, dann werden diese Bilder entschlüsselt und an Apple übermittelt.

Sobald der Mensch, der diese Bilder sichtet, den Verdacht bestätigt, wird das National Center for Missing and Exploited Children (NCMEC) alarmiert. Diese Organisation arbeitet nach eigenen Angaben mit «Autoritäten auf der ganzen Welt» zusammen und stellt sich zum Kindeswohl gegen den breiten und nicht-hinterfragten Einsatz von End-to-End Encryption.

Anders als ein normaler Hash baut NeuralHash laut Seite 5 des White Papers eine Nummer basierend auf dem Inhalt und nicht den Daten des Bildes. NeuralHash schaut sich das Bild an, versteht, was darauf zu sehen ist und generiert darauf basierend einen Wert. Das heisst, selbst wenn ein Farbbild zu einem Schwarzweissbild konvertiert wird, ändert sich das NeuralHash nicht. Auch dann nicht, wenn sich die Dateigrösse verändert. Oder das Bild zugeschnitten wird. Damit will Apple die Hash-Manipulation durch User umgehen.

Technologisch gesehen ist es nicht notwendig, dass ein Apple-Mitarbeiter deine Apple ID kennt. Die Mitarbeiter müssten lediglich feststellen, ob der Tatbestand des Kindesmissbrauchs vorliegt. Die Verknüpfung von Bild und Nutzer kann in den Tiefen der Apple-Datenbanken geschehen und erfordert nicht zwingend, dass die sichtende Person weiss, dass Bild A von Person A stammt. Die sichtende Person muss lediglich die Frage beantworten «Zeigt Bild A Kindesmissbrauch?» sofern das Hash des Bildes das nicht bestätigt.

Ein Menschenrecht ist etwas, das jedem Menschen überall zu jeder Zeit zusteht oder zustehen sollte. Es ist unveräusserlich, kann also nicht abgetreten oder verkauft werden. Auch sind die Menschenrechte unteilbar. Es ist nicht möglich, Menschenrecht A zu vertreten, aber sich gegen Menschenrecht B zu stellen.

Die Vereinten Nationen definieren die Privatsphäre in Artikel 12 in der allgemeinen Erklärung der Menschenrechte eindeutig als Menschenrecht:

Niemand darf willkürlichen Eingriffen in sein Privatleben, seine Familie, seine Wohnung und seinen Schriftverkehr oder Beeinträchtigungen seiner Ehre und seines Rufes ausgesetzt werden. Jeder hat Anspruch auf rechtlichen Schutz gegen solche Eingriffe oder Beeinträchtigungen.

Apple pflichtet dem bei und hat die Privatsphäre zu einer Grundfeste des Konzerns erklärt:

Privatsphäre ist ein Grundrecht. Und Datenschutz zählt bei Apple zu den Kernwerten.

Google singt ein ähnliches Lied. Facebook als soziales Netzwerk, dessen Kernmechanismus die Präsentation der ehemals privaten Daten an der Öffentlichkeit ist, gibt sich auch grosse Mühe, dass nichts Schlimmes mit deinen Daten geschieht.

Apple ist im Jahr 2021 die mächtigste Marke der Welt. Damit geht, wie der Titel bereits impliziert, Macht einher. Wenn Apple etwas macht, dann hat das Signalwirkung. Und: Der Rest der Technologiewelt braucht Apple weit mehr als Apple den Rest der Technologiewelt braucht.

Ein Beispiel: Tile macht seit 2013 Bluetooth Tracker. Den Durchbruch haben sie nicht geschafft, denn unter anderem fehlt Tile das breite Netz aus Geräten, die dein verlorenes Objekt aufspüren kann. 2021 stellt Apple das AirTag vor. Auf einmal sind mit dem «Find My»-Network eine Milliarde Geräte auf der Welt, die dir helfen, dein AirTag zu finden. Tile darf neu auf das «Find My»-Netzwerk zugreifen. Tile braucht Apple weit mehr als dass Apple Tile braucht.

Der sogenannte Apple Effect, Macht gepaart mit Signalwirkung, darf nicht unterschätzt werden. Wenn Apple ein Feature einführt, dann leidet die Konkurrenz, die dieses Feature bereits früher hatte. Und Konkurrenten sehen sich im Zugzwang.

NeuralHash schlägt in der Information Security und bei Privatsphärenaktivisten hohe Wellen. Diese sind nicht nur technologischer Natur, sondern vor allem ethisch-philosophischer.

Wenn Apple deine Bilder nach Anzeichen von Kindesmissbrauch durchsuchen soll, dann muss die Verschlüsselung deiner iCloud Backups umgangen werden. Daher wird in NeuralHash ein Fingerprint «Kindesmissbrauch» erstellt und in die App Photos integriert.

Dann durchsucht die Photos App laut Seite 4 des White Papers deine Bilder auf deinem iPhone, umgeht jede Verschlüsselung elegant. Damit hat Apple einen Weg gefunden, auf zwei Hochzeiten zu tanzen. Sie können die Verschlüsselung haben und sie auch umgehen. Denn die Bilder auf deinem iPhone sind im Klartext gespeichert.

In der Fachsprache wird so etwas eine «Backdoor» genannt. Bisher kann Apple noch an einem gewissen Grad der Verschlüsselung festhalten, selbst wenn die vollständige Verschlüsselung nicht geschieht. Grund: Das FBI und die US-Regierung haben Druck gemacht. Derzeit ist es also möglich, dass Apple Backups entschlüsseln kann. Die Backdoor ist, so weit bekannt, nur via Apples offiziellem Update Channel beeinflussbar.

Damit NeuralHash effektiv gegen Kindesmissbrauch ist, muss jemand definieren, wie Kindesmissbrauch im Bild aussieht. Und: Ab welchem Grad des Kindesmissbrauchs das System anschlägt. Braucht der Fingerprint «Kindesmissbrauch» nur «blaues Auge» oder schlägt das System erst bei «blaues Auge» + «blutige Lippe» an?

Wer entscheidet das? Worauf basieren diese Entscheidungen? Ab wo ist Kindesmissbrauch schlimm genug?

Erschwerend kommt hinzu, dass NeuralHash laut Seite 3 des White Papers unsichtbar ist und du keinen Einfluss darauf hast.

Wenn NeuralHash erst einmal auf die Menschheit losgelassen wird, dann kann es nicht mehr aufgehalten werden. Wenn die Galerie App Stephanie Tresch von hinten erkennen kann, basierend auf ihrem blauen Mantel und der Tatsache, dass sie an einem bestimmten Ort eine Kamera hält, dann kann dieselbe Suchfunktion auf so ziemlich alles und jeden angesetzt werden.

Wer verspricht uns, dass Apple diese Funktion nicht missbraucht?

NeuralHash kann für Gutes wie auch für Böses verwendet werden. Es ist durchaus möglich, dass nach Kindesmissbrauch auch Jagd nach Hautkrebs gemacht wird. Auf der Kehrseite ist es auch möglich, dass Apple ein gigantisches Archiv von Penisbildern anlegt, denn NeuralHash sieht vor, dass Bilder entschlüsselt und übermittelt werden.

Information-Security-Experten wie der Kryptographie-Professor Matthew Green befürchten, dass NeuralHash ein Angriff auf die End-to-End Encryption ist.

«Das ist eine entsetzliche Idee, da sie zur Massenüberwachung unserer Laptops und Smartphones führt», sagt Ross Anderson, Professor für Security Engineering der University of Cambridge, in der Financial Times.

Mit NeuralHash wirst du ständig überwacht. Von deinem Smartphone. Dem Gerät kannst du im heutigen Durchschnittsalltag nicht entkommen. Diese Überwachung ist zentralisiert und wird von Menschen bestimmt, über die du keine Kontrolle hast. Selbst das Gesetz greift bei Mechanismen wie NeuralHash nur bedingt. Zum einen, da die Gesetzgeber dieser Welt recht interessiert an Backdoors sind. Zum anderen, da die Legislaturen in einer Demokratie oft reaktiv und langsam sind. Bis das Gesetz sich solide und nachhaltig mit NeuralHash auseinandergesetzt hat, ist das System nicht nur auf die Menschheit losgelassen, sondern hat sich sogar noch weiterentwickelt.

Die Exekutive in einem jeden System ist stark daran interessiert, dass NeuralHash zum Erfolg wird. Mit so einem System könnten dem Terrorismus Verdächtige gefasst werden, bevor sie eine Straftat begehen. Wenn das System auf Location Data ausgeweitet wird, dann könnten Verbrecher aufgrund ihrer Position zum Tatzeitpunkt festgemacht werden. Wenn NeuralHash ein Fingerprint von «Tatort» + «Kleidung» + «Tatzeit» übergeben wird, dann kann ein Täter- und Bewegungsprofil erstellt werden, da der Täter vielleicht im Hintergrund eines Selfies der Kundin des Cafés gegenüber des Tatorts auftaucht. Das würde die Arbeit der Polizei stark vereinfachen und der Gerechtigkeit könnte effizienter gerecht geworden werden.

Es ist möglich, dass Regierungen Apple dazu zwingen können, NeuralHash – konfiguriert nach arbiträren Faktoren – in alle iPhones ihres Landes einzuspeisen. Ein plakatives Beispiel: Die chinesische Regierung könnte sagen «Apple, du darfst in China keine iPhones verkaufen, ausser wenn NeuralHash uns hilft Uiguren aufzuspüren».

Wenn Apple sich dagegen stellen würde, dann ginge dem Konzern ein grosser Markt verloren. Wenn Apple mitmacht, dann würden Menschen darunter leiden.

Apples Entscheidungen haben Signalwirkung. «Das wird Tür und Tor weit aufmachen», sagt Matthew Green, Security Professor an der John Hopkins University, in der Financial Times, «Regierungen werden die Funktion von allen einfordern.»

Das stellt den Apple Effect auf eine harte Probe und setzt womöglich einen unschönen Präzedenzfall. Wenn Apple mitmacht, dann spricht wenig dagegen, dass Polen mit NeuralHash Jagd auf Homosexuelle macht. Oder Frauen im Iran, die keinen Hijab tragen.

Wenn NeuralHash nach Bildern von Gewalt sucht, dann sucht es nach Faktoren, die nicht nur dann zustande kommen können, wenn Gewalt geschieht. «Blaues Auge», «blutige Lippe» und dergleichen können auch im Sport geschehen. UFC-Kämpferin Cristiane Justino Venâncio alias Cris Cyborg ist nach ihren Kämpfen – und manchmal schon während den Kämpfen – übel zugerichtet.

Wenn sie genug Bilder hat, auf denen sie aus der Nase blutet oder ein blaues Auge hat, dann schlägt NeuralHash an. Eine Anzahl Bilder wird an Apple übermittelt, wo ein Mensch diese Bilder ansieht. Im Rahmen von Cris Cyborgs Alltag ist das nichts aussergewöhnliches. Das würde ein Apple-Mitarbeiter erkennen und das Ticket schliessen. Trotzdem: Die Bilder hat der Mitarbeiter gesehen.

Ein False Positive ist nicht nur ein Verstoss gegen ein Menschenrecht, sondern er geschieht auch noch grundlos. Irgendwer bei Apple schaut einfach ein paar Bilder aus dem privaten Archiv der Kämpferin an. Grundlos.

Die Frage hier ist, ob sogenannte False Positives in Ordnung sind. Und wenn ja, wie oft darf ein False Positive vorkommen, bevor NeuralHash zu weit geht? Wer bestimmt diese Zahl? Wer überwacht diese Zahl?

Apple beschreibt auf Seite 3 des White Papers die Anzahl der False Positives als «extrem niedrig». Auf der folgenden Seite wird von einem False Positive in einer Billion Untersuchungen gesprochen. Zudem würden alle Reports vor der Übermittlung an NCMEC geprüft werden.

Können wir Apple vertrauen?

Apple macht sich einen guten Namen damit, dass der Konzern die Privatsphäre zur firmeneigenen Grundfeste gemacht hat. Aber: Apple hat keinerlei Verpflichtung dies aufrecht zu erhalten.

Ideologie bei Firmen ist immer ein Marketing Tool. Denn bei Firmen zählt nicht – egal, wie oft das ein CEO sagt –, wie viel Gutes die Firma der Welt tun kann. Es zählt einzig und allein das Geld. Apple muss iPhones verkaufen. Apple setzt sich Wachstumsziele, die erfüllt werden müssen. Sobald diese Zahlen nicht mehr stimmen, dann ändert Apple seine Richtung. Genau so, wie es jedes andere Unternehmen auch tun würde.

Autohersteller sind derzeit gerade in so einem Richtungswechsel. Wo vor zehn Jahren Tesla noch als lustiges Kuriosum abgetan wurde, werden ganze Automarken von Benzin auf Elektro umgestellt. Der Umwelt zuliebe, versteht sich. Nicht, weil Gesetzgeber immer mehr restriktive Gesetze für Benzinfahrzeuge erlassen, Steuervergünstigungen für Elektrokäufer sprechen und – nicht zuletzt – die Leute Elektrofahrzeuge kaufen wollen.

Was also verspricht, dass Apple für immer die Privatsphärenschützerin bleibt, die sie heute ist?

Trotz allen hehren Zielen, die Apple mit NeuralHash verfolgen will: Die Funktion ist zu gefährlich, als dass sie nicht als zu grosses Risiko für das Menschenrecht Privatsphäre gesehen werden muss. Apple kann nicht so weit vertraut werden, jeder anderen Firma auch nicht. Dem Gesetzgeber erst recht nicht. Und eine Organisation, die sich aktiv gegen die End-to-End Encryption stellt, sollte nicht ohne Überwachung einen Mechanismus erhalten, mit der sie Verschlüsselungen umgehen kann. Egal, was die Motive sind.

Die Privatsphäre muss unangetastet bleiben. Es darf keine Ausnahmen geben. Menschenrechte stehen auch Verbrechern zu.

Selbst wenn eine Ausnahme viel Gutes bewirken würde, so würde diese Ausnahme einen Präzedenzfall setzen, der kein gutes Ende erlaubt.

Apple hat am 9. August 2021 ein zweites Whitepaper veröffentlicht, das Antworten auf einige der Fragen in diesem Artikel gibt.

Journalist. Autor. Hacker. Ich bin Geschichtenerzähler und suche Grenzen, Geheimnisse und Tabus. Ich dokumentiere die Welt, schwarz auf weiss. Nicht, weil ich kann, sondern weil ich nicht anders kann.

Interessantes aus der Welt der Produkte, Blicke hinter die Kulissen von Herstellern und Portraits von interessanten Menschen.

Alle anzeigen