Hintergrund

Sony Alpha 7 V im Hands-on: Der Platzhirsch ist zurück

von Samuel Buchmann

Letzte Woche hat die NASA eine neue Aufnahme des James-Webb-Weltraumteleskops veröffentlicht. Sie zeigt die Cartwheel Galaxy. Ich will wissen, wie solche Bilder entstehen und ob ich aus den Rohdaten ein besseres Bild als das offizielle zaubern kann.

Das neueste Bild aus dem James Webb Space Telescope (JWST) lässt mich einmal mehr staunen. Darauf zu sehen ist die sogenannte Cartwheel Galaxy (auf Deutsch: Wagenrad-Galaxie) in einer revolutionären Detailtiefe. Sie liegt rund 500 Millionen Lichtjahre entfernt. Ihre einzigartige Form hat sie laut den Forschenden der NASA durch eine Kollision mit einer anderen Galaxie erhalten. Wenn du mehr astronomische Details willst, lege ich dir diesen Artikel der New York Times ans Herz.

Mich als Kamera-Nerd interessieren aber andere Fragen: Wie nimmt das JWST diese Bilder auf? Wie sehen die Rohdaten aus? Wie werden sie entwickelt? Und: Kann ich das auch? Die Antwort zur letzten Frage schon vorweg: Ja, aber niemals so gut wie die NASA.

Zuerst braucht es eine Erklärung, wie die Kameras des JWST ungefähr funktionieren. Du liest richtig: Kameras. Mehrzahl. Genauer gesagt heissen sie in diesem Fall Messinstrumente. Das JWST hat vier Arten davon. Alle zeichnen einen anderen Teil des Sichtfeldes des gigantischen, goldbeschichteten Spiegelmoduls auf, welches das Licht gebündelt zu den Sensoren schickt. Ich konzentriere mich einfachheitshalber auf die zwei Instrumente, die für mein Bild relevant sind: die Near-Infrared Camera (NIRCam) und das Mid-Infrared Instrument (MIRI).

Das Wichtigste vorweg: Alle Farben, die du auf den JWST-Bildern siehst, sind fiktiv. Auf meinem Bild (das linke) genauso wie auf dem der NASA. Die Sensoren zeichnen keine sichtbaren Farben auf, wie deine Canon oder meine Sony zuhause. Stattdessen sind sie dafür gebaut, Infrarot zu sehen. Diese «Farbe» hat längere Wellen, als unser Auge wahrnehmen kann – und lange Wellen sind das Einzige, was von weit entfernten Galaxien bis zu uns durchdringt. Warum das so ist, hat Kollege David vor ein paar Monaten in seinem Artikel genauer erklärt. Kurz gesagt: Das Universum und damit auch die Lichtwellen von weit entfernten Objekten scheinen sich auszudehnen. Zudem durchdringt Infrarot den kosmischen Staub besser.

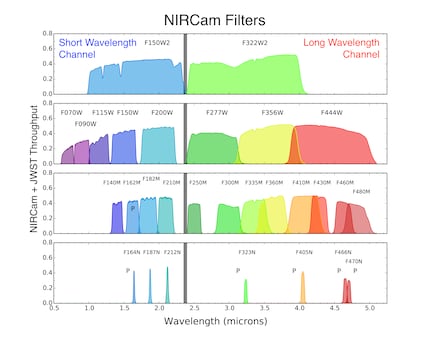

Wie du in der Grafik siehst, zeichnet der Sensor der NIRCam Wellenlängen von etwa 0,6 μm bis 5 μm auf. Die Abkürzung «μm» steht für Mikrometer, ein Tausendstel eines Millimeters. Die Wellen von sichtbarem Rot sind bis etwa 0,7 μm lang. Die NIRCam schiesst kein einzelnes Bild, in dem all diese «Farben» kombiniert enthalten sind, wie wir es von unseren Kameras kennen. Sie hat nur einen monochromen Sensor – es ist eine Schwarz-Weiss-Kamera.

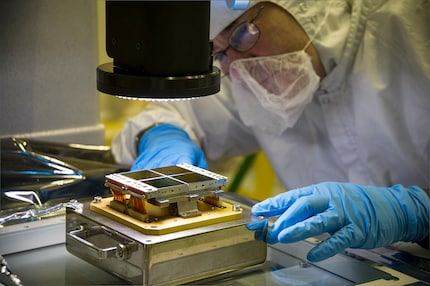

Um trotzdem die verschiedenen Wellenlängen zu unterscheiden, macht die NIRCam mehrere Belichtungen vom selben Bildausschnitt. Dabei wird jedes Mal ein anderer Filter vorgeschoben, der nur eine spezifische Wellenlänge an Licht (oder eben: Infrarot-Farbe) durchlässt. Wie das mechanisch aussieht, siehst du im folgenden Video des MIRI-Filterrads.

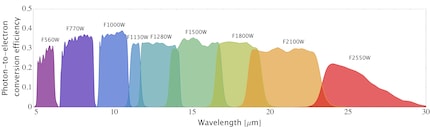

Noch weiter geht der Sensor des Mid-Infrared Instruments (MIRI). Er kann Wellenlängen von 5 μm bis 28 μm aufzeichnen. Das ist revolutionär, denn damit sieht das MIRI tiefer und detaillierter ins Weltall, als wir es bisher je konnten. Zum Vergleich: Das Hubble Teleskop sieht nur Wellenlängen bis zu 2,4 μm. Damit der Sensor von MIRI funktioniert, muss er mindestens −267° Celsius kalt sein. Das ist mit ein Grund, warum die NASA ihn ins All geschossen hat, mit einem Segel beschattet und trotzdem noch aktiv kühlen muss.

Wenn alles richtig läuft, ist das Resultat aus all den Sensoren und Filtern ein Haufen Schwarz-Weiss-Bilder vom selben Objekt. Diese Rohdaten sind öffentlich zugänglich, und zwar auf dieser Website im Design direkt aus den 90ern. Ein Tutorial, wie du die Daten filtern und downloaden kannst, findest du hier. Für mein Bild schränke ich die Suche nach dem Datum ein, an dem es veröffentlicht wurde, nämlich am 2. August 2022.

Meine Beute: Zehn Unterordner, beschriftet mit dem Filter, der für die jeweilige Aufnahme vor dem Sensor war – zum Beispiel f1000w, der nur Licht im Bereich von 10 μm durchlässt. Die Files in den Ordnern sind in Formaten, die ich noch nie gesehen habe. Nach kurzer Recherche stellt sich heraus, dass es FITS-Dateien sind, ein Format für astronomische Daten, das die NASA eigens 1981 entwickelt hat. Öffnen lässt es sich mit speziellen Programmen. Zum Beispiel mit PixInsight, für das es 45-tägige Testlizenzen gibt. Oder mit einfacheren Freewares wie dem FITS Liberator.

Ich öffne die zehn Bilder in PixInsight. Ein paar Youtube-Tutorials und verzweifelte Google-Suchen später habe ich daraus TIFFs exportiert. Schon besser. Falls dich dieser Prozess genauer interessiert oder du es nachmachen willst, zeige ich dir in folgendem Video, welche Knöpfe du dafür drücken musst.

Mit den zehn Bildern im Format für Normalsterbliche wechsle ich zu Photoshop, das eher in meiner Komfortzone liegt. Hier lege ich sie erstmal alle in einem einzigen Dokument als Ebenen übereinander. Das Ziel ist nun, alle zehn Ebenen zu einem einzelnen, farbigen Bild zu verschmelzen. Dazu muss ich sie durchlässig machen und gleichzeitig einfärben. Wie das im Detail funktioniert, erkläre ich dir wieder im Video.

Zentral bei der Bearbeitung: Ich weise jedem der zehn monochromen Ausgangsbilder eine eigene Farbe zu. Welche das sein soll, ist im Prinzip Geschmacksache. Fake sind sie sowieso alle. Ich entscheide mich, die Reihenfolge aus unserem sichtbaren Farbspektrum zu übernehmen. Aus dem Bild mit den kürzesten unsichtbaren Wellenlängen – das mit dem f090w-Filter – mache ich deshalb die Farbe mit den kürzesten sichtbaren Wellenlängen: Violett. Danach folgen Blau, Türkis, Grün und so weiter.

Die Bilder aus der NIRCam sind deutlich hochauflösender (etwa 18 Megapixel) als die des MIRI (nur rund 1 Megapixel). Im Fall der Cartwheel Galaxy scheinen die Aufnahmen mit den Filtern im Bereich von 2 μm bis 4 μm das beste Verhältnis von Bildinformationen und Rauschen zu haben. Aus ihnen kann ich am meisten rauskitzeln. Die Bilder des MIRI müssen stark hochskaliert werden. Auch die Tonwerte muss ich massiv verändern, um überhaupt etwas zu erkennen. Trotzdem sind am Ende Dinge darauf zu sehen, welche die NIRCam nicht zeigt – vor allem das von mir gelb eingefärbte MIRI-Bild mit dem 10-μm-Filter fliesst deutlich ins fertige Composite ein.

Mit meinem Endergebnis bin ich nur halb zufrieden. Die Farben gefallen mir zwar besser als die der NASA. Aber im offiziellen Bild sind massiv mehr Details und weniger Bildartefakte erkennbar – insbesondere im Bereich der «Speichen» der Galaxie. Das liegt unter anderen daran, dass ich elementare Dinge wie Kalibrierungsbilder komplett ignoriert habe. Dafür reicht mein Wissen nicht und der Aufwand einer sauberen Bildentwicklung wäre für mich gigantisch. Ich überlasse das in Zukunft lieber wieder den Profis – ein spannender Einblick in die Welt des Weltraumteleskops war das Experiment aber allemal.

Mein Fingerabdruck verändert sich regelmässig so stark, dass mein MacBook mich nicht erkennt. Der Grund: Sitze ich nicht vor einem Bildschirm oder stehe hinter einer Kamera, hänge ich oft an den Fingerspitzen in einer Felswand.

Interessantes aus der Welt der Produkte, Blicke hinter die Kulissen von Herstellern und Portraits von interessanten Menschen.

Alle anzeigen